ステート・オブ・AI ガイドでは、人工知能・機械学習分野の最新動向についての記事を毎週配信しています。購読などの詳細につきましては、こちらをご覧ください。また、Twitter アカウントの方でも情報を発信しています。

2020年ももう年の瀬が迫っていますが、今年も機械学習・人工知能の分野は話題には事欠きませんでした。自然言語処理の分野では、GPT-3 や T5 など強力なモデルが次々と登場し、ビジョンの分野でも、トランスフォーマーの応用が本格的に始まりました。国際会議や arXiv などで発表される論文の数も、これまでの通り、指数関数的に増えるというトレンドが続いています。

本記事では、2020年に arXiv において機械学習・自然言語処理・コンピュータービジョンの各分野で発表された全論文を自然言語処理の技術を使って解析することによって、「2020年に最も言及された機械学習トピック」のランキングを作って発表します。これらを予め把握しておくと、多くの論文を読むのがずっと楽になることでしょう。

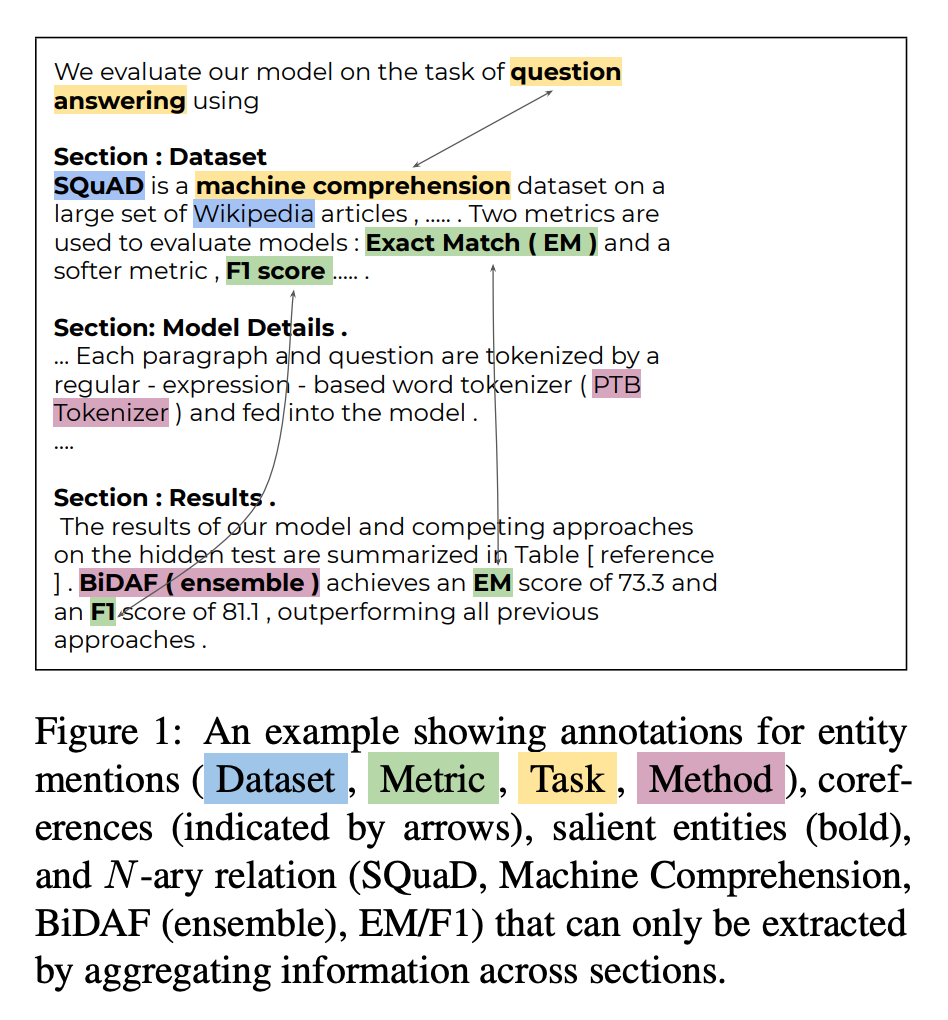

具体的には、2020年に arXiv で発表された論文のタイトルと概要を arXiv API を使って取得、SciREX を使って固有表現抽出します。SciREX は、固有表現をタスク・指標・データセット・手法のタイプ毎に抽出できるので、これらのタイプ別に集計することが可能になります。固有表現抽出・ランキング集計法の詳細は、最後の「手法の詳細」の節で解説します。

2020 年に最も言及されたトピック (タイプ別)

本記事では、機械学習全般 (cs.LG)、自然減言語処理(cs.CL)、コンピュータービジョン (cs.CV) の3分野に限って分析をします。arXiv にはこの他にも人工知能・機械学習に関連したカテゴリが数多くあるのですが、単純化のためにこれらのカテゴリに絞りました。

機械学習 (cs.LG)

まず、機械学習分野で最も言及されたトピックを、タイプ別に見てみます。

| データセット | 指標 | タスク | 手法 |

|---|---|---|---|

| CIFER-10 | 精度 (accuracy) |

分類 (classification) |

ニューラルネットワーク (neural network) |

| ImageNet | 頑健性 (robustness) |

機械学習 (machine learning) |

深層ニューラルネット (DNN) |

| MNIST | 複雑さ (complexity) | 訓練 (training) |

畳み込みニューラルネット (CNN) |

| COVID-19 | 収束 (convergence) |

学習 (learning) |

深層学習 (deep learning) |

| CIFER-100 | 計算コスト (computational cost) |

汎化 (generalization) |

機械学習 (machine learning) |

| SVHN | 分類精度 (classification accuracy) |

予測 (prediction) |

強化学習 (reinforcement learning) |

| 胸部X線 (chest x-ray) |

計算量 (computational complexity) |

推論 (inference) |

敵対的生成ネットワーク (GAN) |

| COCO | 精度 (precision) |

自然言語処理 (NLP) |

機械学習モデル (machine learning models) |

| KITTI | F1スコア (f1 score) |

強化学習 (reinforcement learning) |

グラフニューラルネット (graph neural network) |

| サンプル複雑性 (sample complexity) |

人工知能 (artificial intelligence) |

分類器 (classifier) |

こう見ると、CIFER-10/100、ImageNet、MNIST など、特にデータセットのほとんどが、画像認識、コンピューター・ビジョン関連であることが分かります。機械学習の中でも、大きな存在感を出していますね。

手法を個別に見ると、やはり「ニューラルネットワーク一色」であることが分かります。また、「ニューラルネットワーク (neural network)」や「深層学習 (deep learning)」など汎用的な手法に混ざって、「グラフニューラルネット (graph neural network)」がランクインしています。後からも詳しく見ますが、グラフベースの手法は最近の大きなトレンドと言っても良いでしょう。

自然言語処理 (cs.CL)

続いて、自然減言語処理分野で最も言及されたトピックを、タイプ別に見てみます。

| データセット | 指標 | タスク | 手法 |

|---|---|---|---|

| COVID-19 | 精度 (accuracy) |

自然言語処理 (NLP) |

BERT |

| 英語 (English) |

F1 スコア (F1 score) |

機械翻訳 (machine translation) |

言語モデル (language model) |

| BLEU スコア (bleu score) |

質問応答 (question answering) |

トランスフォーマー (transformer) |

|

| Wikipedia | 頑健性 (robustness) |

固有表現認識 (named entity recognition) |

LSTM (long short term memory) |

| GLUE | 単語誤り率 (word error rate) |

自動音声認識 (automatic speech recognition) |

ニューラルネットワーク (neural network) |

| ドイツ語 (German) |

質 (quality) |

ニューラル機械翻訳 (neural machine translation) |

深層ニューラルネット (deep neural network) |

| SQuAD | 精度 (precision) |

下流タスク (downstream tasks) |

自然言語処理 (NLP) |

| LibriSpeech | 再現率 (recall) |

分類 (classification) |

RNN (recurrent neural network) |

| Wikidata | 翻訳の質 (translation quality) |

感情分析 (sentiment analysis) |

ニューラルモデル (neural models) |

| ヒンディー (Hindi) |

評価指標 (evaluation metrics) |

生成 (generation) |

畳み込みニューラルネット (CNN) |

自然言語処理で最も言及されたトピックは、ずばり「COVID-19」と言っても過言ではないでしょう。COVID-19 関係の論文データセットである CORD-19 が公開され、ワークショップ W-NUT 2020 において COVID-19 の情報抽出シェアードタスクが開催されるなど、大きな注目を集めました。

また、手法としては 「BERT」 や 「言語モデル (language model)」「トランスフォーマー (transformer)」が上位を独占しています。2018年に始まった、トランスフォーマーベースの事前学習言語モデルを使った転移学習の波は、未だに衰えるところを知りません。

コンピューター・ビジョン (cs.CV)

続いて、コンピューター・ビジョン分野で最も言及されたトピックを、タイプ別に見てみます。

| データセット | 指標 | タスク | 手法 |

|---|---|---|---|

| ImageNet | 精度 (accuracy) |

セグメンテーション (segmentation) |

畳み込みニューラルネット (convolutional neural network) |

| CIFER-10 | 頑健性 (robustness) |

分類 (classification) |

深層ニューラルネットワーク (deep neural network) |

| COCO | 分類精度 (classification accuracy) |

コンピューター・ビジョン (computer vision) |

深層学習 (deep learning) |

| KITTI | 精度 (precision) |

物体検出 (object detection) |

ニューラルネットワーク (neural network) |

| CIFER-100 | 計算コスト (computational cost) |

検出 (detection) |

敵対的生成ネットワーク (GAN) |

| COVID-19 | 最大事後確率 (maximum a posteriori) |

訓練 (training) |

深層 CNN (deep CNN) |

| MNIST | 速度 (speed) |

セマンティック・セグメンテーション (semantic segmentation) |

深層学習モデル (deep learning models) |

| Cityscapes | 計算量 (computational complexity) |

画像分類 (image classification) |

転移学習 (transfer learning) |

| 胸部X線 (chest x-ray) |

汎化能力 (generalization ability) |

汎化 (generalization) |

分類器 (classifier) |

| RGB 画像 (RGB images) |

感度 (sensitivity) |

推論 (inference) |

深層学習モデル (deep learning methods) |

データセットを見ると、CIFER-10/100、ImageNet、MNISTなど、「定番の」データセットと並んで、COVID-19、胸部X線、などがランクインしています。胸部X線画像からの COVID-19 の症状の検出などが盛んに研究されたためと言えるでしょう。

また、タスクとしては、(セマンティック)セグメンテーションが最も多く言及されています。自動運転や、医療画像処理などに幅広く応用される重要なタスクであることが分かります。

2020年に言及が増えたトピック

続いて、2020年と去年 (2019年) の言及数を比べることによって、各分野の「トレンド」を詳しく見てみましょう。具体的には、2020年に言及の多かったトピックについて、2019年と比較して言及が統計的に有意に多いかどうかを分析しました。

機械学習 (cs.LG)

まず、機械学習分野で言及されたトピックのトレンドを見てみます。以下の表は、2020年で言及の多かったトピックのトップ20と、それぞれの言及数の過去2年間の月次トレンド (言及される論文の相対数) を可視化しています。2020年の論文数×過去2年の平均言及確率と比較して、2020年に言及が統計的に有意に多かったトピックは緑で、少なかったトピックは赤で示しています。

| ランク | トピック | トレンド | 論文数 (2019) | 論文数 (2020) |

|---|---|---|---|---|

| 1 | 精度 (accuracy) | 2209 | 2971 | |

| 2 | 機械学習 (machine learning) | 1503 | 2079 | |

| 3 | ニューラルネットワーク (neural network) | 1530 | 1984 | |

| 4 | 深層ニューラルネット (deep neural network) | 1585 | 1969 | |

| 5 | 深層学習 (deep learning) | 1174 | 1548 | |

| 6 | 畳み込みニューラルネット (CNN) | 1150 | 1296 | |

| 7 | 強化学習 (reinforcement learning) | 955 | 1204 | |

| 8 | 分類 (classification) | 838 | 1127 | |

| 9 | 頑健性 (robustness) | 680 | 970 | |

| 10 | 訓練 (training) | 635 | 828 | |

| 11 | 学習 (learning) | 650 | 815 | |

| 12 | 汎化 (generalization) | 486 | 646 | |

| 13 | 敵対的生成ネットワーク (GAN) | 601 | 602 | |

| 14 | 人工知能 (artificial intelligence) | 340 | 568 | |

| 15 | CIFAR-10 | 438 | 560 | |

| 16 | COVID-19 | 1 | 551 | |

| 17 | 機械学習モデル (machine learning models) | 365 | 547 | |

| 18 | グラフニューラルネット (graph neural network) | 230 | 530 | |

| 19 | 自然言語処理 (NLP) | 307 | 529 | |

| 20 | 予測 (prediction) | 375 | 515 | |

| 合計 | 19,268 | 25,272 |

これを見ると、深層ニューラルネット (deep neural network) 、畳み込みニューラルネット (CNN) 、敵対的生成ネットワーク (GAN) などの言及は、論文数の増加に比べて伸びが有意に小さいことが分かります。これらは、非常に汎用的な技術となったので、論文でわざわざ言及されることが少なくなったということかもしれません。

一方、COVID-19 や、グラフニューラルネット (graph neural network) などの言及が伸びているのは、上で述べた通りです。また、自然言語処理 (NLP) は、トランスフォーマーや BERT などの普及により、分野全体が盛り上がっている印象を受けます。

機械学習分野で言及が有意に伸びたのは、この他に 連合学習 (federated learning)、データ拡張 (data augmentation)、メタ学習 (meta-learning) などがあります。本ブログでも、機会を見つけて解説記事を書いてみたいと思います。

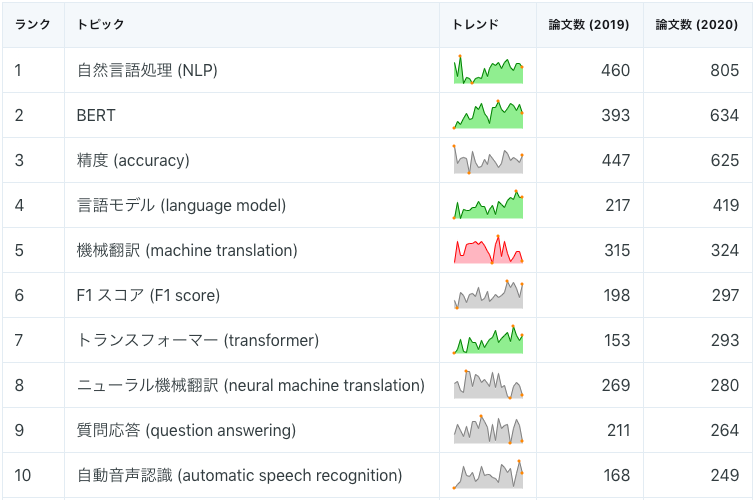

自然言語処理 (cs.CL)

次に、自然言語処理分野で言及されたトピックのトレンドを見てみます。

| ランク | トピック | トレンド | 論文数 (2019) | 論文数 (2020) |

|---|---|---|---|---|

| 1 | 自然言語処理 (NLP) | 460 | 805 | |

| 2 | BERT | 393 | 634 | |

| 3 | 精度 (accuracy) | 447 | 625 | |

| 4 | 言語モデル (language model) | 217 | 419 | |

| 5 | 機械翻訳 (machine translation) | 315 | 324 | |

| 6 | F1 スコア (F1 score) | 198 | 297 | |

| 7 | トランスフォーマー (transformer) | 153 | 293 | |

| 8 | ニューラル機械翻訳 (neural machine translation) | 269 | 280 | |

| 9 | 質問応答 (question answering) | 211 | 264 | |

| 10 | 自動音声認識 (automatic speech recognition) | 168 | 249 | |

| 11 | 固有表現認識 (named entity recognition) | 167 | 219 | |

| 12 | LSTM (long short term memory) | 220 | 206 | |

| 13 | BLEU スコア (BLEU score) | 199 | 204 | |

| 14 | ニューラルネットワーク (neural network) | 174 | 173 | |

| 15 | 下流タスク (downstream tasks) | 88 | 173 | |

| 16 | 感情分析 (sentiment analysis) | 120 | 172 | |

| 17 | 分類 (classification) | 103 | 168 | |

| 18 | COVID-19 | 0 | 165 | |

| 19 | 自然言語理解 (natural language understanding) | 80 | 158 | |

| 20 | 生成 (generation) | 105 | 155 | |

| 合計 | 5,391 | 6,893 |

BERT、言語モデル (language model)、トランスフォーマー (transformers) などは、近年最も「ホットな」技術と言っても良く、2019年と比べても言及が増えています。また、下流タスク (downstream tasks) の言及が増えているのは、転移学習の普及によるものだと思われます。

一方で、機械翻訳 (machine translation)、ニューラル機械翻訳 (neural machine translation)、BLEU スコア (BLEU score) など、翻訳系のトピックは、言及があまり伸びていません。機械翻訳は依然として重要な応用ですが、2017年のトランスフォーマーの衝撃から一巡して、トレンドの中心が BERT をはじめ事前学習+言語モデルに移ったためとも言えます。

ランク外で言及が有意に増加したのは、他に事前学習モデル (pre-trained models) や "fine-tuning"、RoBERTa などがあります。RoBERTa は特に、2019年→2020年の間で言及が6倍に増えており、BERTに代わるデファクト事前学習モデルの座を獲得しつつあります。

コンピューター・ビジョン (cs.CV)

| ランク | トピック | トレンド | 論文数 (2019) | 論文数 (2020) |

|---|---|---|---|---|

| 1 | 精度 (accuracy) | 1711 | 2270 | |

| 2 | 畳み込みニューラルネット (CNN) | 1629 | 1689 | |

| 3 | 深層ニューラルネット (deep neural network) | 899 | 1127 | |

| 4 | 深層学習 (deep learning) | 782 | 1027 | |

| 5 | セグメンテーション (segmentation) | 758 | 930 | |

| 6 | 分類 (classification) | 603 | 801 | |

| 7 | ニューラルネットワーク (neural network) | 556 | 777 | |

| 8 | 頑健性 (robustness) | 503 | 703 | |

| 9 | コンピューター・ビジョン (computer vision) | 505 | 615 | |

| 10 | 敵対的生成ネットワーク (GAN) | 577 | 587 | |

| 11 | 物体検出 (object detection) | 415 | 529 | |

| 12 | 検出 (detection) | 392 | 510 | |

| 13 | 訓練 (training) | 340 | 469 | |

| 14 | ImageNet | 361 | 455 | |

| 15 | セマンティック・セグメンテーション (semantic segmentation) | 380 | 440 | |

| 16 | 画像分類 (image classification) | 307 | 365 | |

| 17 | 機械学習 (machine learning) | 272 | 362 | |

| 18 | CIFAR-10 | 303 | 360 | |

| 19 | COVID-19 | 1 | 344 | |

| 20 | 汎化 (generalization) | 240 | 339 | |

| 合計 | 11,595 | 14,920 |

コンピューター・ビジョン分野では、COVID-19 が伸びている一方、畳み込みニューラルネット (CNN) や 敵対的生成ネットワーク (GAN) など、どちらかというと使い古された技術については、言及が伸びていないという傾向があります。

ランク外を見てみると、上で見た胸部X線 (chest x-ray)、CT (computed tomography) などの医療画像応用系のトピックについての言及が増えていました。教師なし分野適応 (unsupervised domain adaptation) なども伸びており、先週紹介したデータ拡張・教師なし表現学習とも合わせて、今年のトレンドの一つであると言っても良いでしょう。

手法の詳細

以下では、上記のランキングを算出した方法の詳細を書いておきます。分析に使ったスクリプトはこちらにあります。

まず、arXiv から、2019年、2020年の該当分野 (cs.LG, cs.CL, cs.CV) の論文のタイトル、アブストラクトを全て取得します。arXiv のメタデータは、全てパブリックドメインライセンスになっており、自由に利用ができます。データの取得には、arXiv API の Python ライブラリを使用しました。分析の対象となった論文は、全分野合わせて 83,334本です。

続いて、取得したタイトルとアブストラクトから、機械学習関係の言及を抽出します。今回は、SciREX から訓練した固有表現抽出システムを使いました。SciREX 自体は、固有表現とそれらの間の関係などを文書単位でタグ付けした論文のデータセットなのですが、公式のリポジトリ に SciBERT + CRF に基づいたベースラインのモデルを訓練するためのスクリプトがあり簡単に利用できるので、それを利用しています。(なお、SciREX は、固有表現抽出以外にも、言及間の共参照関係なども付与されており、ベースラインもそれに対応できるのですが、今回は固有表現抽出の部分だけを使っています)

抽出した言及は、例えば cnn, cnns, convolutional neural network, convolutional neural networks などの簡単な表記ゆれを、手で作った辞書で正規化した後、出現する論文数をカウントし、ランキング化します。言及が、期待される数と比べて有意に大きいか小さいかの判定にはカイ二乗検定を使っています。

「トレンド」のグラフは、2019年〜2020年の各月ごとに、その言及が現れる論文数をその月に出版された論文の総数で割って正規化した値を、 jQuery Sparklines を使って可視化しています。

本記事で使用したデータセット(論文のタイトル、アブストラクト、抽出された固有表現のリスト)は、ダウンロードページ にて配布しています(有料会員限定とします)。

関連記事